De store språkmodellene er trent på form, ikke innhold – og er derfor perfekte bullshittere. Så lenge vi fortsetter å se på KI-chatbotter som «sparringspartnere», er det et stort problem.

De store språkmodellene bygger på statistisk prediksjon av språklige tegn i en tekst. Siden de har trent på store mengder tekst om ulike tema og i ulike sjangre, kommer den ofte med opplysninger som er riktige. Modellen har for eksempel lest orda «pølse» og «brød» i samme tekster, i samme setninger, og til og med i samme frase så ofte at den tilsynelatende «kjenner til» konseptet «pølse i brød». Slik blir modellene gode «stokastiske papegøyer», som datalingvist Emily Bender har kalt dem, men dårlige informasjonskilder.

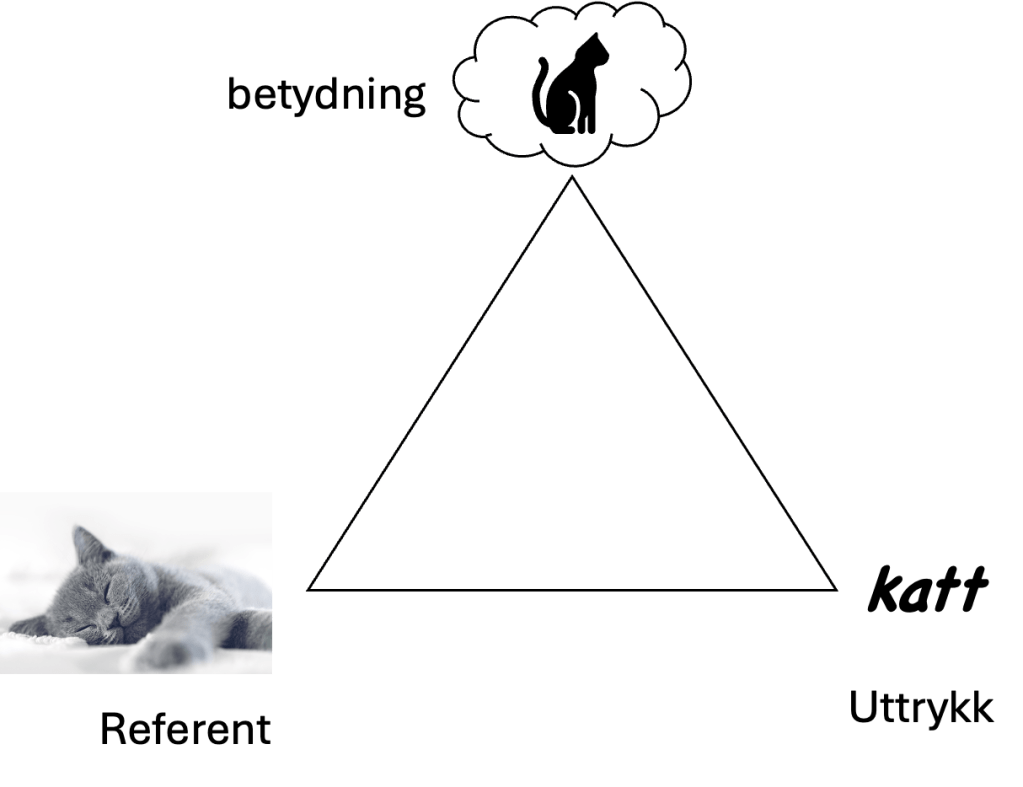

Språklige tegn (ord, uttrykk, fraser m.m.) som katt, røre eller hatsk har 1) et uttrykk (skriftbildet «katt» eller lyden /kat/), 2) en betydning (‘dyr med pels og poter som kan mjaue’) og 3) en referanse – en kopling til den eller de faktiske kattene du snakker om når du bruker ordet katt. De store språkmodellene har ikke direkte referanser til virkeligheten, men har registrert det språklige uttrykket utallige ganger sammen med andre språklige uttrykk. Derfor kan den beregne seg fram til både betydning og grammatiske mønstre som passer for det gitte ordet.

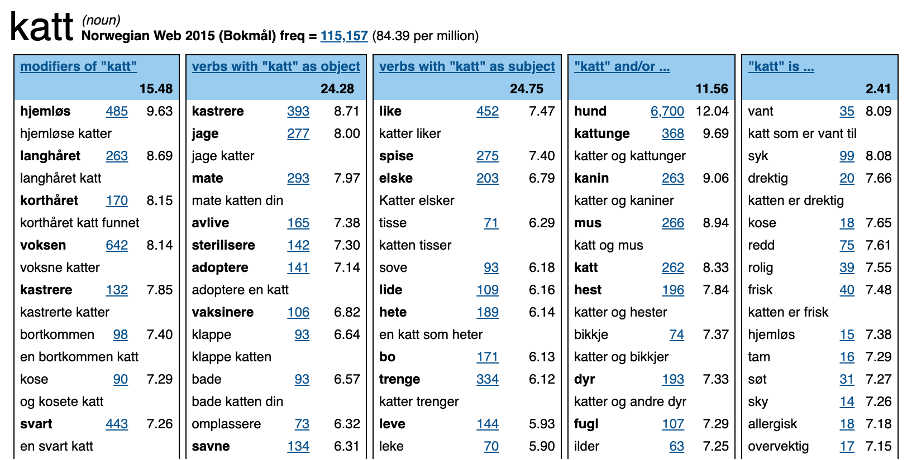

Under viser jeg et eksempel på hvordan det språklige uttrykket «katt» oppfører seg i et tekstkorpus, nemlig HaBiT Norwegian Web 2015, som er en stor, søkbar samling bokmålstekster fra nett i 2015. Ordskyfiguren viser hvilke ord som språklig sett «oppfører seg» mest likt som ordet katt, som har størst sannsynlighet for å kunne erstatte katt i en gitt setning eller frase. Det betyr ikke at de er synonymer, men at de forekommer i nokså lik grad som katt med uttrykk som kosete __, adoptere en __, __-en min osv. (se tabellen under). Her kan også hund eller gutt passe inn, men ikke slakteferdig eller blinklys eller nedover. De oppfører seg annerledes språklig – for eksempel pleier de ikke være (del av) objektet til verbet adoptere.

HaBiT Norwegian Web 2015: «Thesaurus»-diagram for katt, som viser ord språklig sett som oppfører seg likt som katt.

HaBiT Norwegian Web 2015: «Word sketch» for katt, dvs. ulike ord og fraser som forekommer statistisk ofte med katt.

Ut fra slike mønstre som de jeg har vist over, bare i en ekstremt mye større skala, kan de store språkmodellene kople sammen språklige tegn (tokens – ord, orddeler, tegn, m.m.) og bruke koplingene til å lage nye tekststrenger, for eksempel om at nordmenn liker både pølse i lompe og pølse i brød, og at katter bør vaksineres mot katteinfluensa og liker å tisse i blomsterbed.

Språkmaskinene er, som Elizabeth Weil har formulert det, den platonske ideen for en bullshitter, slik bullshittere er beskrevet i essayet On Bullshit av Harry Frankfurt: «Bullshitters, Frankfurt argued, are worse than liars. They don’t care whether something is true or false».

Et annet mye brukt ord for dette – at språkmodellene finner på ting som ikke stemmer – er at språkmodellene «hallusinerer». Termen «hallusinasjoner» er imidlertid misvisende, for det første fordi språkmodellene ikke opplever noen ting. For det andre fordi de feilaktige fabrikasjonene ikke er feil eller noen «sykdom» i en generativ KI-modell. Tvert imot er det dette de store språkmodellene er skapt til å gjøre: å gjette og høres sikre ut når de gjetter. Det er irrelevant om det de produserer, er sant eller ikke.

Det å antropomorfisere de store språkmodellene, bl.a. gjennom menneskemetaforer som tenke, forstå, resonnere, lære og vite, kan gi oss overdreven tillit til dem. Også utseendet til KI-chatbotene, som likner på vanlige chatteprogram, støtter opp under antropomorfiseringa. Når vi tror chatbotene forstår, er veien kort til å tillegge dem intensjon og moral. Det er en feilslutning. Faren ved å ikke se modellene for det de er – sannsynlighetsmodeller som høres ut som mennesker – er at vi glemmer hvor lett de forvrenger virkeligheten.

Selvfølgelig kan mennesker også bullshitte, ljuge og vri på historier. Men vi kan ikke gå rundt mistroiske og konstant anta at alle vi snakker med, holder på sånn. Når jeg spør mannen i gata om han kan fortelle litt om hva som kjennetegner setnings- og frasestrukturen i urnordisk grammatikk, forventer jeg at han sier «det aner jeg ikke», eller noe slikt. Det sier ikke de store språkmodellene, for det er ikke det de er lagd for. De genererer som regel heller noe bullshit ut fra de mønstrene den har sett i treningsdataene og/eller gjennom internettsøk, og skriver kanskje noe som kjennetegner setnings- og frasestrukturen i et språk som er bedre beskrevet enn urnordisk. Mennesker sier «jeg tror» eller «veit ikke» når de er usikre, sånn at samtalepartneren kan ta stilling til hva de skal gjøre med den usikre informasjonen. Chatboter gjør som regel ikke det, men framstiller gjetninger som sikker viten.

En språkmodell er morsom til mye, men den er stort sett bare nyttig i sammenhenger der det ikke gjør noe om svara er bullshit. For eksempel til forvrengning av tekster, til å idémyldre, til å lage tullespråk, eller til å eksperimentere med ulike sjangerstiler, osv. Men: Tenk deg nøye om før du bruker den som en «sparringspartner», «studievenn» eller «orakel i lomma». En god, menneskelig studievenn eller lærer er kanskje ikke så tålmodig, svarer kanskje ikke like fort og på like mye som en KI-chatbot, men hen er som regel åpen om sine begrensninger. «KI-vennen» din gir inntrykk av å ha svar på omtrent alt og ikke minst at den bryr seg om deg. Den retter dessuten neppe på misoppfatningene du kommer med inn i chatten: «Så klart! Jeg beklager feilen. To pluss to er fem».

Carl Bergstrom og Jevin West skriver i The bullshit machines om språkmodeller at «their power comes from a superhuman ability to bullshit. This ability is their greatest strength—yes, it can be genuinely useful—and also their biggest threat». Så til alle som forholder seg til tekst og data: Brett opp ermene og begynn møkkinga. For å bli bedre til å oppdage bullshit anbefaler jeg nettsida til Bergstrom og West, og boka deres Calling bullshit.